Алгоритмите на Facebook за засичане на езика на омразата работят все по-ефективно и повече, хвалят се от компанията. Каква е точността на тези системи с изкуствен интелект обаче продължава да бъде мистерия, разказва Wired.

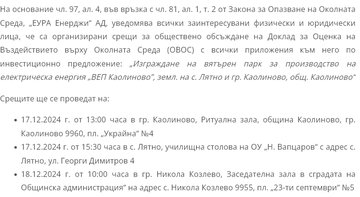

От май 2018 г. хората на Зукърбърг съобщават за това как прилагат "стандартите на общността", или правилата на социалната мрежа на всяко тримесечие от годината. В последното се съобщава, че компанията е премахнала 9,6 млн. елемента съдържание за първата четвърт на 2020 г. Това е нов рекорд и увеличение с 3,9 млн. от последната четвърт на 2019 г.

Както става ясно, 88,8% от това съдържание е установено от специалните алгоритми на компанията, за които се говори от началото на десетилетието. Модераторите премахват едва 11,2% от съдържанието с омраза.

Това, което Facebook не дава като данни, е колко подобно съдържание пропуска и колко съдържание бива изтрито по погрешка от алгоритмите.

Има данни, че въпреки повечето потребители, които са оспорвали решения, налице са по-малко връщания на изтрито съдържание. Компанията призна, че пандемията и намаленият състав в офисите са наложили промяна на начина на обжалване.

Според много анализатори и потребители алгоритмите на социалната мрежа изпускат много постове, изразяващи омраза, според други пък се трият немалко невинни съобщения.

Клуб Z

Коментари

Добави коментар